人工智能(AI)将改变人们的工作和日常生活,但也有弊端:AI计算机中心会消耗大量电力和水,为其处理芯片供电并冷却其散发的热量。

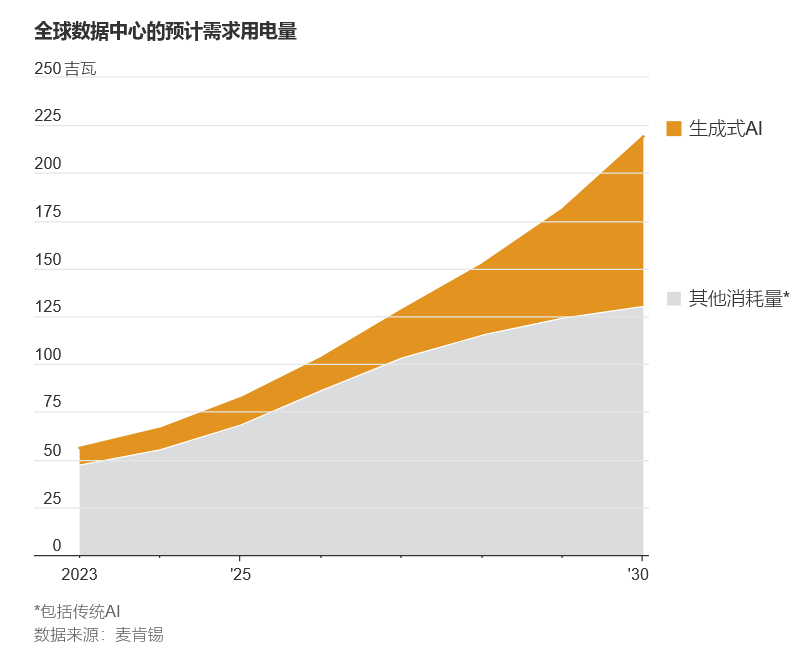

咨询公司麦肯锡(McKinsey)的预测显示,到2030年,美国各类数据中心的年用电量将从目前占美国总用电量的3%-4%升至11%-12%,其中AI是主力军。

与此同时,加州大学河滨分校(University of California, Riverside)和得州大学阿灵顿分校(University of Texas at Arlington)的研究人员表示,到2027年,全球AI的水需求量可能超过丹麦每年的总取水量,或相当于英国的一半。

耗电耗水给这一行业带来物流和公众形象的问题。一些公用事业公司难以满足AI企业的需求,当地社区也予以抵制,担心增加使用量会推高电价并耗尽水资源。

包括亚马逊(Amazon)、Alphabet旗下谷歌(Google)、Meta和微软(Microsoft)在内的最大的AI提供商表示,他们正在努力实现碳中和,并补充比他们使用量还多的水,即使这些公司还在继续建设大型数据中心。

“建设数据中心将更加困难,尤其是在能源本来就很宝贵或水资源可能稀缺的地方,”技术咨询公司Gartner的研究副总裁Ed Anderson说。但他补充道,“经济机会足够丰富,提供商会找到办法的。”

以下是科技公司和研究人员希望采取的有助于减少AI电力和水需求的措施。

提高芯片效率

解决耗电问题的一种方法是降低芯片的耗电量。全球最大的AI处理器制造商英伟达(Nvidia)表示,其最新款的Blackwell芯片的能效将比之前的高端版本强25倍左右。与此同时,亚马逊、谷歌、Meta和微软正在设计自己的处理芯片,即是为了降低成本,也是为了让它们更省电。

“每一代都比上一代效率高很多,”谷歌副总裁兼工程研究员Partha Ranganathan谈到该公司的处理器时说。

不同的水源

用于冷却数据中心的设备本身也带来一个问题:这些设备需要消耗大量的水,这些水从何而来?谷歌表示,其全球数据中心在2023年使用了约61亿加仑水,相当于每年用于灌溉和维护美国西南部40个高尔夫球场的用水量。

加州大学河滨分校和得州大学阿灵顿分校的研究人员称,OpenAI的GPT-3模型每回答10到50次用户询问,就会消耗相当于16.9盎司瓶装水的水量。OpenAI对此不予置评。

数据中心的用水通常来自市政供水系统。但在水资源短缺的时代,将饮用水转用于工业用途在一些地方造成紧张。这促使AI公司开始寻找其他水源,包括雨水、经过处理的废水或工厂生产过程中剩余的水。

例如,亚马逊在加州圣克拉拉的数据中心使用回收废水进行冷却。这些水来自该市污水处理系统,经过三个步骤的处理去除99%的杂质。

更智能的AI训练

一些研究人员尝试谨慎控制AI模型在训练期间吸收的信息种类和数量。通常,训练所谓的大语言模型AI,比如OpenAI的ChatGPT和微软的Copilot,需要从互联网和其他地方获取数千亿个单词,然后学习它们之间的关系。

这需要耗费大量能源和水资源。斯坦福大学的一份报告显示,训练名为BLOOM的AI模型在3个半月的时间里消耗的电力足以供美国普通家庭使用41年。

加州大学河滨分校电气与计算机工程系教授Shaolei Ren表示,在用水方面,训练名为LaMDA的谷歌AI模型大约消耗了200万升水,足以装满大约5,000个浴缸。这些水包括用于发电以及用于给计算机降温的水。谷歌对这项研究不予置评,但表示该公司“致力于以环保的方式为我们的数据中心降温”。

一种可能的解决方案是让AI去除冗余和低质量的数据,而不是对整个互联网上的内容来者不拒。这样做的目的是,当用户向AI系统提问时,AI可以更轻松地在一个规模小得多的数据集中进行筛选。

一些研究人员表示,这可以降低电力消耗。

专家们指出,限制信息接收的AI系统产生“幻觉”(给出错误或误导性答案)的可能性也更低,而且由于涵盖的数据质量更高,因此能做出更切题的回答。微软发现,该公司一个精简版AI在常识和逻辑推理方面的表现超过了更大的AI。

降低功耗

多所大学的研究人员发现, 限制AI计算机的用电量只会对结果产生轻微影响,比如处理时间略有增加。

麻省理工学院(Massachusetts Institute of Technology)和东北大学(Northeastern University)的专家表示,将Meta的一个AI功耗降低22%-24%,只会让查询的响应速度降低5%-8%。“这些技术可以明显降低能耗,”研究人员表示。他们还说,这种方法还降低了处理器的运行温度,从而有望减少冷却需求。

Meta对这项研究不予置评,但表示自“十多年前我们开始设计第一个数据中心”以来,该公司一直在努力提高数据中心的能源效率。

与此同时,密歇根大学(University of Michigan)、华盛顿大学(University of Washington)和加州大学圣迭戈分校(University of California, San Diego)的一个团队设计了一种算法,调节训练过程中使用的电力。他们表示,这项技术可以将电力消耗降低多达30%。

向用户展示AI的影响

一些研究人员认为,企业应该让用户更多地了解AI对环境的影响,让他们在使用这项技术时做出更明智的决定。加州大学河滨分校的Ren建议,AI提供商应披露每次查询大约消耗的电力和水量,类似于谷歌把每次行程将产生的碳排放量告知搜索航班的人。

另一个建议是为AI系统的能效设计一个评级体系,类似于美国政府对家用电器和其他产品的能源之星(Energy Star)评级。机器学习工具公司Hugging Face的AI研究员萨莎·卢乔尼(Sasha Luccioni)表示,这样一个体系可能帮助人们根据能耗为不同的任务选择不同的AI模型。

利用绿色能源

学术界和其他人士还提出了另一些建议,试图通过使用绿色能源将AI的环境影响降至最低。例如,企业可以在水力发电丰富的挪威或地热资源丰富的冰岛等拥有丰富低排放能源的国家建设更多的数据中心。企业还可以在一天中的不同时间段在不同地点进行AI计算,例如在白天部署大量使用太阳能的计算机中心,或是在夜间风力更可靠时部署风力发电的计算机中心。

为计算机降温

数据中心的计算机会散发出巨大的热量,为防止电子元件损坏,其温度必须保持在一定范围内,通常是华氏64至72度。传统上,这是通过大功率空调来实现的。但空调消耗的电力占一个典型数据中心总耗电量的40%,而将热量排放到外部空气的冷却塔则会消耗大量水。

为此,数据中心行业正在转向液体冷却技术,让一种特殊液体或冷水循环到位于处理器芯片顶部的“冷板”,使其保持在安全高效的温度范围内。这种被称为直接芯片液体冷却的系统比传统方法耗电量更低(据英伟达称,耗电量低30%左右),因为相比于将冷空气吹过电子元件,液体在带走电子元件热量方面的效果要好得多。

另一种正在开发的方法被称为浸没式冷却,即将计算机本身放置在装有冷却液的大型容器中。微软云计算子公司Azure的首席技术官Mark Russinovich说,虽然这种方法展现出初步的希望,但人们对其中经常使用的化学物质存在环境方面的担忧。

与此同时,一些公司正在使用能够承受更高温度且不需要太多冷却的运算设备。谷歌表示,其数据中心的能效已经是典型数据中心的1.8倍,这在一定程度上是通过将内部温度提高到华氏80度实现的。根据能源之星计划,数据中心每升温1华氏度,就能节省4%-5%的能源成本。

文章末尾固定信息